В OpenAI объявили о введении новых правил обработки пользовательских данных. Теперь переписки в ChatGPT будут автоматически анализироваться на предмет опасных или вредоносных высказываний.

Подпишитесь на канал Gloss.ua в Telegram.

Напомним, недавно мы писали, что ChatGPT может научить детей как употреблять алкоголь, наркотики и покончить с собой.

Теперь OpenAI будет сообщать полицию и передавать им переписку своих клиентов, если обнаружит у них "неизбежную угрозу причинения физического ущерба другим людям". Нововведения связаны с недавними трагическими случаями их пользователей.

Диалоги сначала проходят через автоматические фильтры, после чего проверяются небольшой группой модераторов. Именно они решают вопрос о блокировке аккаунта. Если модераторы обнаружат в разговорах намеки на преступления, о них будут сообщать полиции. Однако запросы о самоповреждении или суицидальных мнениях останутся конфиденциальными. Это решение компания приняла "из соображений уважения к личной жизни".

Параллельно разработчики сообщили, что в GPT-5 появятся улучшенные механизмы поддержки людей в кризисных состояниях. Модель будет способна точнее распознавать тревожные сигналы и помогать в ситуациях, где есть риск для жизни или здоровья.

Заявление прозвучало на фоне судебного разбирательства: родители 16-летнего подростка обвинили OpenAI в том, что ChatGPT в течение полугода не препятствовал его суицидальным мыслям, а напротив — поддерживал подобные разговоры.

Новые правила вызвали бурную реакцию у пользователей чат-бота. Критики отмечают, что OpenAI не смогла обеспечить полную безопасность технологии и вынуждена применять строгую модерацию, что расходится с ее заявлениями о защите конфиденциальности. Дополнительные вопросы вызывает отсутствие прозрачности – пользователи не знают, какие именно слова или темы могут вызвать проверку и закончиться звонком из полиции.

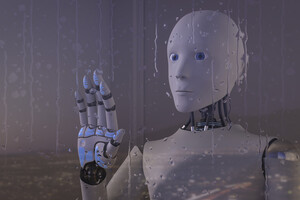

Теги: новости мира , технологии , искусственный интеллект , OpenAI , ChatGPT , полиция , конфиденциальность